過去幾個月來,人工智慧社群因為蘋果公司發表的兩篇影響深遠的研究論文而掀起熱烈討論。第一篇,illusion-of-thinking-the-debate-that-is-shaking-the-world-of-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic"(2024 年 10 月),第二篇、 「思考的幻象」(2025 年 6 月),質疑所謂的大型語言模型的推理能力,在業界引起不同的反應。

正如我們先前在深入探討中分析的 「進步的幻覺:模擬通用人工智慧卻無法實現」,人工推理的問題觸及了我們對機器智能的根本認知。

Apple 的研究人員對大型推理模型 (Large Reasoning Models, LRM)進行了系統分析 - 這些模型會在提供答案前產生詳細的推理軌跡。結果令人驚訝,而且對許多人而言,也令人震惊。

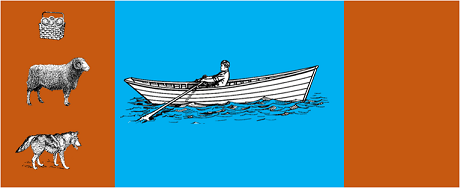

這項研究讓最先進的模型接受經典演算法謎題的考驗,例如:

結果顯示,即使是問題表述上的微小變化,也會導致表現上的顯著差異,這說明推理的脆弱性令人擔憂。正如 AppleInsider 報導,「當僅改變 GSM-Symbolic 基準問題中的數值時,所有模型的效能都會下降」。

來自人工智慧社群的回應很快就出現了。Open Philanthropy 的 Alex Lawsen 與 Anthropic 的 Claude Opus 合作,發表了一篇詳盡的反駁文章,題目為 思考的幻覺」。對 Apple 研究的方法和結論提出質疑。

當 Lawsen 以其他方法重複測試時 (要求模型產生遞歸函數,而非列出所有步驟),結果大不相同。Claude、gemini和 GPT 等模型正確解決了有 15 條記錄的河內塔問題,遠遠超過 Apple 報告零成功的複雜度。

Gary Marcus長期批評法律學家的推理能力,他認為 Apple 的研究結果證實了他 20 年來的論點。根據 Marcus 的說法,法學院院士在「已經解決的問題的良好解決者」的同時,仍然在「分佈轉換」(即超越訓練資料的概括能力)方面奮力掙扎。

此討論也擴散到專業社群,例如 Reddit 上的 LocalLlama開發人員和研究人員討論開放原始碼模式和本地實作的實際影響。

這場辯論並非純學術性的。它對以下方面有直接影響:

正如幾份 技術見解越來越需要結合以下技術的混合方法:

舉個簡單的例子:一個協助記帳的 AI 助理。當您問「這個月我在旅遊上花了多少錢?」時,語言模型會理解,並擷取相關參數(類別:旅遊,期間:本月)。但是查詢資料庫、計算總和並檢查財務限制的 SQL 查詢呢?那是由確定性程式碼完成的,而不是神經模型。

觀察家不難發現,蘋果的論文是在 WWDC 前不久發表,令人質疑其策略動機。正如9to5Mac 的分析,"蘋果論文發表的時間 - 就在 WWDC 之前 - 引起了一些關注。這是研究的里程碑,還是在更廣泛的人工智能領域重新定位蘋果的戰略舉動?

蘋果的論文所引發的爭論提醒我們,我們對人工智慧的了解仍處於早期階段。正如我們在 上一篇文章中指出,模擬推理和真實推理之間的區別仍然是我們這個時代最複雜的挑戰之一。

真正的教訓不在於 LLM 是否能夠達到人類所謂的「推理」能力,而是我們該如何建立既能發揮其優點,又能彌補其缺點的系統。在這個人工智能已經在改變整個行業的世界裡,問題不再是這些工具是否「聰明」,而是如何有效且負責任地使用它們。

企業級 AI 的未來可能不在於單一的革命性方法,而是在於幾種互補技術的智慧型協調。在這種情況下,批判且誠實地評估我們工具能力的能力本身就成為了一種競爭優勢。

最新進展(2026年1月)

OpenAI 釋出 o3 與 o4-mini:2025 年 4 月 16 日,OpenAI 公開發布 o3 與 o4-mini,這兩款為 o 系列中最先進的推理模型。這些模型現可主動運用工具,結合網路搜尋、檔案分析、視覺推理與圖像生成等功能。 o3 在 Codeforces、SWE-bench 和 MMMU 等基準測試中創下新紀錄,而 o4-mini 則針對高量推理任務優化了性能與成本。這些模型展現了「圖像思考」能力,能將內容視覺化轉化以進行更深入的分析。

DeepSeek-R1撼動人工智慧產業:2025年1月,DeepSeek發布開源推理模型R1,其性能媲美OpenAI o1,訓練成本僅需600萬美元(相較於西方模型動輒數億美元)。 DeepSeek-R1證明推理能力可透過純強化學習激發,無需人工標註示範。該模型已成為數十個國家App Store與Google Play的免費榜冠軍應用程式。 2026年1月,DeepSeek發表了長達60頁的擴展論文,揭示了訓練的秘訣,並坦承蒙地卡羅樹搜索(MCTS)等技術無法應用於通用推理。

Anthropic 更新克勞德的「憲法」:2026年1月22日,Anthropic 為克勞德發布了一份長達23,000字的新憲法,從基於規則的方法轉變為基於對倫理原則的理解。 該文件成為首份正式承認人工智慧可能具備意識或道德地位的大型人工智慧企業框架,聲明Anthropic關注克勞德的「心理健康、自我意識與福祉」。

辯論愈演愈烈:2025年7月的一項研究複製並改進了蘋果公司的基準測試,證實當複雜度適度增加時(約如漢諾塔的8個圓盤),LRM仍會顯現認知限制。研究人員證明這不僅取決於輸出限制,更源於真實的認知局限,凸顯出相關爭論遠未落幕。

若要深入瞭解貴組織的 AI 策略和強大解決方案的實施,我們的專家團隊可提供客製化諮詢服務。